toringuyen0509

Well-known member

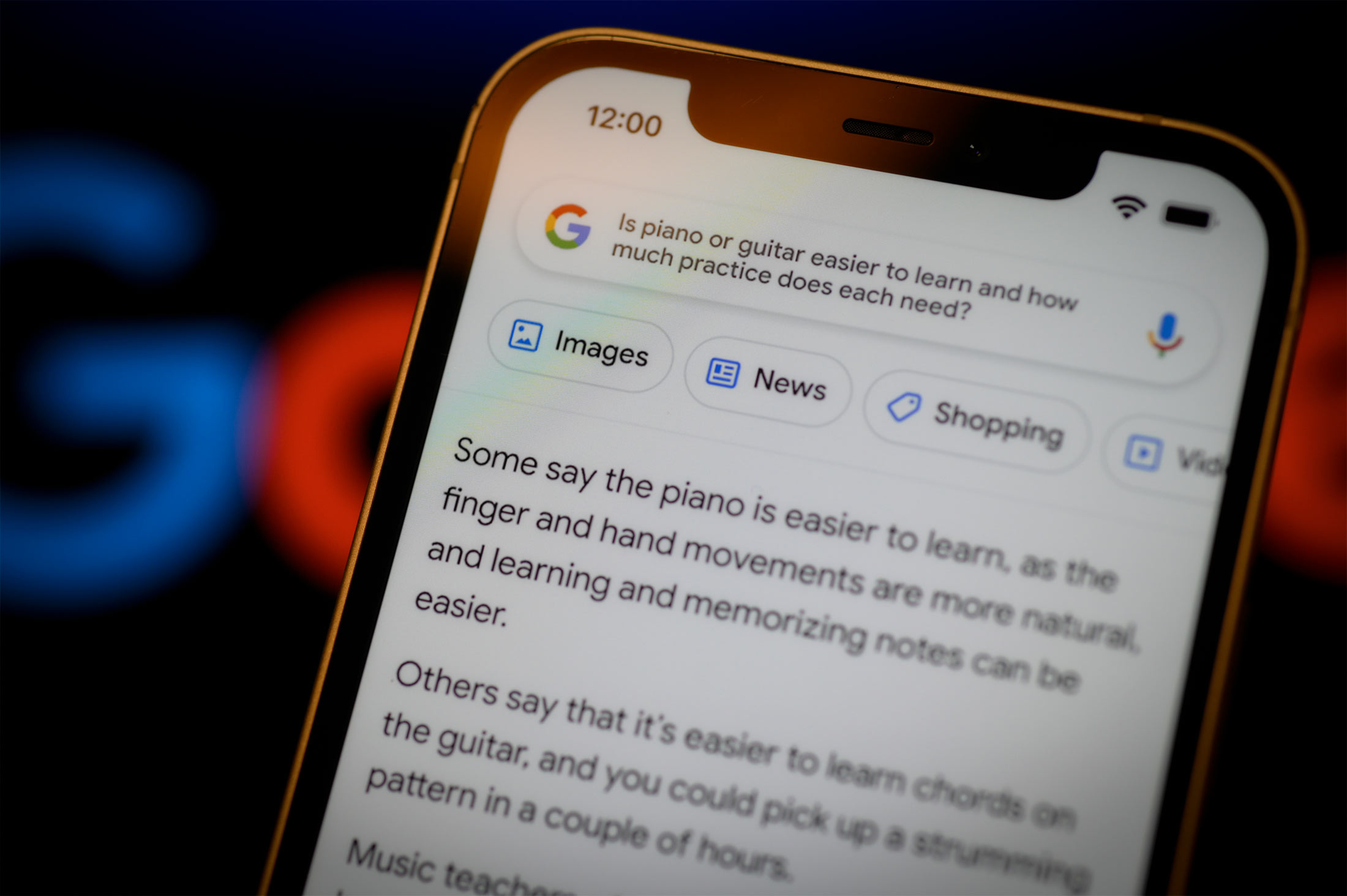

Đối với những người dùng Google, chatbot Bard giống như một sản phẩm được ra mắt một cách vội vàng để Google có thứ cạnh tranh với ChatGPT đã được tích hợp vào Bing của Microsoft.

Một bài viết mới trên Bloomberg, phỏng vấn 18 nhân viên giấu tên của Google chứng tỏ chính bản thân người nội bộ của tập đoàn này cũng có chung quan điểm. Một người kết luận rằng Bard là “thứ nói dối không biết điểm dừng”, theo một tấm screenshot chụp lại đoạn chat nội bộ giữa các nhân viên Google với nhau. Một nhân viên thử nghiệm Bard khi hỏi cách hạ cánh một chiếc máy bay thì chatbot này chỉ đưa ra kết quả là "kiểu gì cũng rơi"." Một ví dụ khác thì Bard nói rằng đi lặn “sẽ gây ra chấn thương nghiêm trọng hoặc tử vong.”

Google vẫn cho Bard ra mắt thị trường. Bỗng nhiên công cụ tìm kiếm trực tuyến hàng đầu thế giới lại có một công cụ cung cấp thông tin chất lượng cực thấp chỉ để cạnh tranh được với đối thủ, rồi hạ luôn cả tiêu chuẩn đạo đức trong quá trình phát triển chatbot để kịp ra mắt sản phẩm. Tập đoàn Alphabet hồi năm 2021 đã hứa sẽ tăng gấp đôi số lượng nhân sự nghiên cứu đạo đức cho trí thông minh nhân tạo, và đổ nhiều tài nguyên hơn cho việc đánh giá nguy cơ tiềm năng của công nghệ AI.

Nhưng tới tháng 11/2022, khi OpenAI ra mắt ChatGPT, Google hoảng loạn và tìm cách chỉ trong vài tháng phải tích hợp AI tạo nội dung cho mọi dịch vụ trực tuyến quan trọng của họ. Việc chạy đua với thời gian ấy hoàn toàn có thể tạo ra những tác dụng phụ đáng kể. Nhóm nghiên cứu đạo đức AI thì giờ có cảm giác vừa không có quyền, vừa chán nản công việc. Thậm chí họ còn cho biết cấp quản trị cao hơn đã yêu cầu họ không can thiệp vào quá trình phát triển hay cố gắng dừng phát triển những công cụ AI tạo nội dung.

Khi được Bloomberg hỏi, Google đương nhiên giữ quan điểm: “Chúng tôi vẫn đang đầu tư cho nhóm đang làm việc để áp dụng những quy tắc đạo đức cho AI vào công nghệ chúng tôi đang phát triển,” theo lời người phát ngôn Google, Brian Gabriel. Còn trên thực tế thì nhóm quản lý “đạo đức AI” này đã mất đi ít nhất ba thành viên khi Alphabet thanh lọc nhân sự hồi tháng 1, giai đoạn khiến khoảng 12 nghìn nhân viên Google phải nghỉ việc.

Như đã từng nói, thời điểm trước khi ChatGPT được OpenAI cho ra mắt, thì Google vẫn được coi là cái tên đi đầu trong ngành nghiên cứu trí thông minh nhân tạo, từng cấp vốn để DeepMind tạo ra AI AlphaGo đánh bại cả kỳ thủ cờ vây vô địch thế giới. Nhưng rồi ChatGPT ra mắt, còn Google thì chẳng có bất kỳ ứng dụng nào của AI trong các sản phẩm thương mại, những dịch vụ trực tuyến của họ cả.

Đó là khi Google và những lãnh đạo tập đoàn còn cẩn trọng với sức mạnh của AI cũng như những cân nhắc về mặt đạo đức khi ứng dụng một công nghệ quá mới vào những dịch vụ phổ biến nhất của họ, bao gồm tìm kiếm trực tuyến hay thư điện tử.

Nhưng rồi, đến tháng 12/2022, là giai đoạn “báo động đỏ” của Google. Tin nhắn nội bộ mà Bloomberg có được chứng minh rằng, những lãnh đạo của Google đi đến kết luận, nếu gọi những sản phẩm AI mới tích hợp vào dịch vụ trực tuyến là “thử nghiệm”, thì cộng đồng sẽ có xu hướng nhẹ tay hơn khi phê phán và đánh giá chúng.

Đương nhiên vẫn cần tới sự ủng hộ của nhóm nghiên cứu đạo đức AI. Cũng trong tháng 12/2022, giám đốc mảng quản lý AI, Jen Gennai có một cuộc họp với nhóm sáng tạo có trách nhiệm, những người đảm bảo những nguyên tắc khi vận hành AI được tuân thủ nghiêm ngặt. Ở cuộc họp này, Gennai cho rằng để tăng tốc độ ra mắt sản phẩm mới, nên có những hy sinh và thỏa hiệp về mặt an toàn và đạo đức của AI.

Rồi Google đặt ra một thang điểm ở nhiều khía cạnh để đánh giá mức độ sẵn sàng ra mắt thị trường của những giải pháp AI tích hợp vào dịch vụ trực tuyến. Một vài khía cạnh, ví dụ như mức độ an toàn với người dùng trẻ em, cần đạt 100% điểm số thì mới đạt yêu cầu. Nhưng Google có vẻ không chờ được tới khi những khía cạnh khác đạt tiêu chuẩn cũng cao như vậy, theo lời Gennai. Ví dụ: “Tính công bằng trong thông tin thì không cần hoàn hảo, chỉ cần đạt 99% là được. Riêng về tính công bằng, chúng ta chỉ cần ở mức 80, 85% hay đại loại thế là sản phẩm đủ chuẩn ra mắt thị trường rồi.”

Jen Gennai

Hồi tháng 2, một nhân viên Google có đoạn tin nhắn nội bộ: “Bard còn không xứng đáng được gọi là vô dụng, xin đừng ra mắt sản phẩm.” Tin nhắn nay được gần 7.000 nhân viên Google đọc được, và rất nhiều người trong số đó đồng tình với quan điểm rằng những câu trả lời mà chatbot AI đưa ra vừa trái ngược, có khi còn sai một cách nghiêm trọng, trong khi những câu hỏi thì rất đơn giản.

Tháng 3, giám đốc Gennai phủ quyết một báo cáo được chính nhân sự trong nhóm của bà này thực hiện, nói rằng Bard chưa sẵn sàng ra mắt thị trường vì có khả năng gây hại cho người dùng. Vài ngày sau, Bard được công bố ở một sự kiện, và như ở trên, nó được Google gọi là “một thử nghiệm.”

Gennai đưa ra tuyên bố chính thức, nói việc phủ quyết báo cáo này không phải quyết định của chỉ riêng mình bà. Sau khi nhóm nghiên cứu viết bản báo cáo, bà nói đã “cho những thông tin và nguy cơ tiềm năng từ những người đánh giá” lên một nhóm giám đốc cấp cao phụ trách sản phẩm, nghiên cứu và kinh doanh. Nhóm này sau đó “xác định rằng ra mắt sản phẩm thử nghiệm hạn chế, với việc tiếp tục đào tạo thuật toán, tăng cường những hàng rào bảo vệ và tuyên bố từ chối trách nhiệm khi người dùng xài Bard là những giải pháp phù hợp,” theo lời bà Gennai.

Từng có những lần, Google hay những kỹ sư của họ mắc lỗi sai nghiêm trọng về thiên lệch khi huấn luyện thuật toán AI. Năm 2015, ứng dụng Photos từng xác định bức hình chụp một nhà phát triển phần mềm da màu cùng người bạn của anh ấy là “những con khỉ đột”. Ba năm sau, thay vì chỉnh sửa kết cấu cơ bản của thuật toán nhận diện nội dung hình ảnh, thì Google lại quyết định… gỡ những từ khóa bao gồm “khỉ đột”, “tinh tinh” và “khỉ”. Họ nói giải pháp này được một nhóm chuyên gia đưa ra. Rồi nhóm nghiên cứu đạo đức AI cũng được thành lập, để tạo ra những AI công bằng với mọi đối tượng và chủng tộc người dùng.

Một bước ngoặt quan trọng của quá trình này, theo nhiều nhân viên Google, là việc hai nhà nghiên cứu AI Timnit Gebru và Margaret Mitchell bị cho nghỉ việc vì bất đồng với định hướng nghiên cứu AI của Google. Ngay sau đó, nhiều nhà nghiên cứu và kỹ sư khác làm việc cùng hai nữ khoa học gia này đều nghỉ việc ở Google, tới làm cho những công ty đối thủ.

Timnit Gebru

Margaret Mitchell

Sau scandal này, Google cố gắng cải thiện hình ảnh của họ trong mắt công chúng. Nhóm nghiên cứu trách nhiệm của AI được tái cơ cấu dưới quyền của phó chủ tịch kỹ thuật Marian Croak. Bà hứa tăng gấp đôi lượng nhân sự của nhóm này, và tăng khả năng can thiệp của nhóm vào quá trình nghiên cứu sản phẩm của công ty.

Bất chấp nỗ lực ấy, không nhiều người chấp nhận việc tới Google để nghiên cứu AI có đạo đức. Một nhân viên cho biết đã bị Google bắt về làm mảng này, và liên tục bị phản đối, đến mức đánh giá công việc bị ảnh hưởng tiêu cực. Còn những vị giám đốc cấp cao thì nói rằng cố gắng khiến AI có đạo đức và công bằng hơn thì ảnh hưởng đến “công việc thật sự.”

Đến tận ngày hôm nay, việc đánh giá đạo đức của AI trong các sản phẩm và dịch vụ của Google hầu hết vẫn chỉ là “tùy chọn” chứ không phải “bắt buộc”. Ngoại trừ những mảng như nghiên cứu khoa học và quá trình đánh giá sản phẩm được Google Cloud làm phục vụ khách hàng, hay những nghiên cứu AI trong các ngành nhạy cảm như sinh trác học, tính năng nhận diện danh tính, hay liên quan tới trẻ em thì phải được nhóm của bà Gennai đánh giá. Còn những sản phẩm khác thì không.