Trịnh Thành Trung

Well-known member

Vì một lý do nào đó, trong vài ngày qua đã rộ lên những thông tin về việc điện thoại Samsung, đặc biệt là Samsung dòng cao như Galaxy S23 đã "fake" hình ảnh khi chụp ở chế độ chụp mặt trăng, theo đó kể cả khi chúng ta nhìn không thấy gì, chỉ thấy một quầng sáng chói lóa thì điện thoại Samsung vẫn có thể ghi lại những hình ảnh cực kỳ chi tiết ở chế độ chụp mặt trăng. Vậy thì sự thật ở đây là gì, và liệu chúng ta có nên tái định nghĩa lại khái niệm hình ảnh khi mà hình ảnh thực tế mắt chúng ta thấy và những gì camera ghi lại được đang ngày một khác biệt?

1. Đầu tiên, chúng ta cần nhìn toàn cảnh vấn đề chụp ảnh mặt trăng.

Mình thấy rất lạ là vụ ảnh mặt trăng lại rộ lên gần đây. Ngay từ hồi 2019, khi Huawei P30 Pro ra mắt thì người ta đã thực hiện nhiều thử nghiệm với chế độ mặt trăng của máy và rút ra kết luận là, khi P30 Pro xác định người dùng đang chụp mặt trăng, nó sẽ tự động "chồng" thêm một layer lên phía trên mặt trăng thật để thể hiện các chi tiết đẹp và sắc nét hơn. Do dù sau đó Huawei phủ nhận việc này nhưng các trang review lớn trên toàn thế giới đều không tái hiện được những gì mà Huawei công bố, do vậy người ta vẫn tạm cho rằng Huawei có tội trong việc này.

Tiếp đến, bản thân Samsung cũng từng gặp rắc rối tương tự trên Galaxy S21 Ultra hồi 2021, tức 2 năm trước. Một người dùng đã sử dụng hình ảnh mặt trăng thật tải trên mạng, sau đó cho hiển thị trên màn hình, rồi dùng Galaxy S21 Ultra chụp lại. Anh này thậm chí còn vẽ mặt cười lên ảnh mặt trăng trên màn hình, bạn có thể xem lại tại đây.

QUẢNG CÁO

Ở đây, người ta kết tội về 2 vấn đề:

- Liệu Samsung có chồng một layer lên trên như Huawei hay không?

- Liệu Samsung có vẽ thêm các chi tiết hay không?

Một thử nghiệm khác cũng chứng minh điều tương tự. Ngay từ 2021 thì người ta đã thử đánh lừa S21 Ultra rồi. Khi này, họ dùng một trái bóng bàn với các luồng sáng để giả lập làm mặt trăng, S21 Ultra không bị đánh lừa và không vẽ bất cứ chi tiết bề mặt mặt trăng lên quả bóng bàn như hình ảnh bạn có thể thấy bên dưới.

Ngoài ra, người ta cũng "lục" các dòng code của Galaxy S21 Ultra và không phát hiện ra bất cứ một tập lệnh nào liên quan đến việc đè các lớp hình ảnh lên hình ảnh thật, do vậy có thể giải oan cho Samsung trong vấn đề số 1: họ không chồng một layer mặt trăng lên, tức không fake hình ảnh một cách lộ liễu.

2. Người dùng Reddit thử gì trên camera Galaxy S23 Ultra?

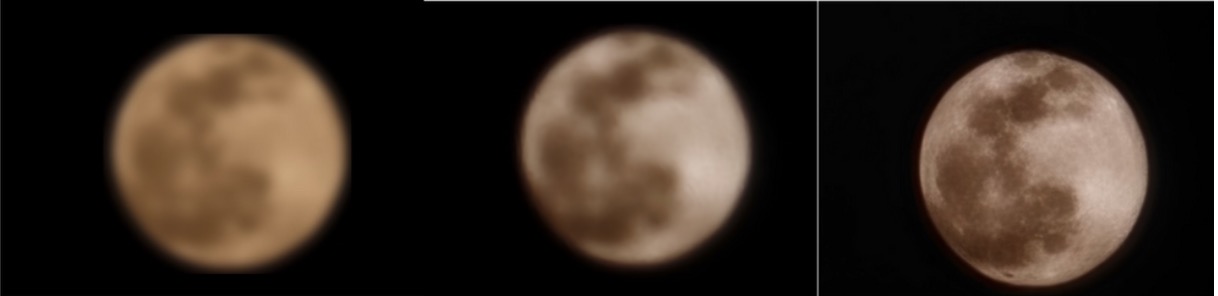

Đầu tiên, bạn ibreakphotos này tải một tấm hình mặt trăng độ phân giải cao trên mạng về, giảm chất lượng nó còn 170x170 pixel và áp hiệu ứng làm mở để loại bỏ toàn bộ chi tiết của mặt trăng như hình phía dưới.

Sau đó hiển thị ở màn hình máy tính và dùng Galaxy S23 Ultra chụp lại ở chế độ mặt trăng.

Đây là hình ảnh mà anh ấy ghi nhận lại được, đặt cạnh hình ảnh bị làm mờ. Theo ibreakphotos, nếu chi tiết đã không có ngay từ ban đầu thì làm sao ảnh chụp ra lại có được? Bạn kết luận rõ ràng là Samsung fake các chi tiết mặt trăng.

QUẢNG CÁO

Anh này thậm chí còn photoshop 2 mặt trăng nằm đè lên nhau, thì một mặt trăng được làm thêm các chi tiết và một mặt trăng không, bạn có thể xem chi tiết tại đây

3. Vậy Samsung đã làm gì? Liệu họ có vẽ thêm các chi tiết hay không?

Trả lời ngắn gọn là không, cho bạn nào còn đang thắc mắc mà muốn trả lời nhanh, ở một khái niệm nào đó thì Samsung "vô tội" trong việc này. Có 2 bằng chứng rất rõ ràng, mà thực ra đã được phân tích từ 2021 cho chúng ta thấy điều đó.

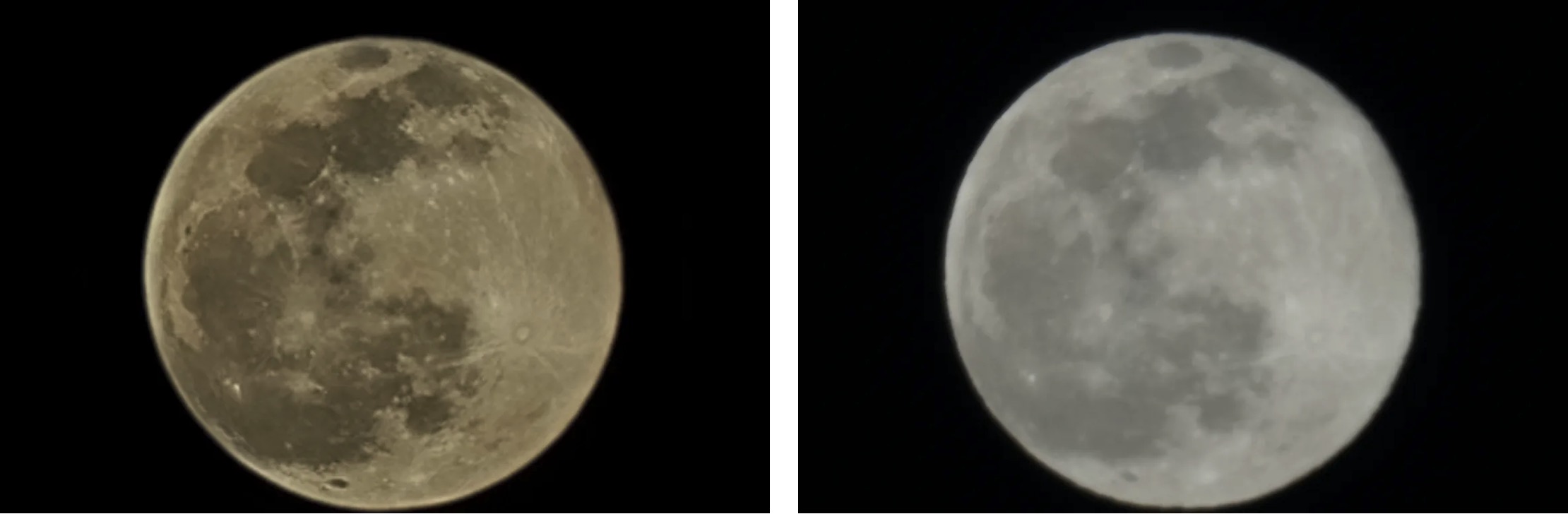

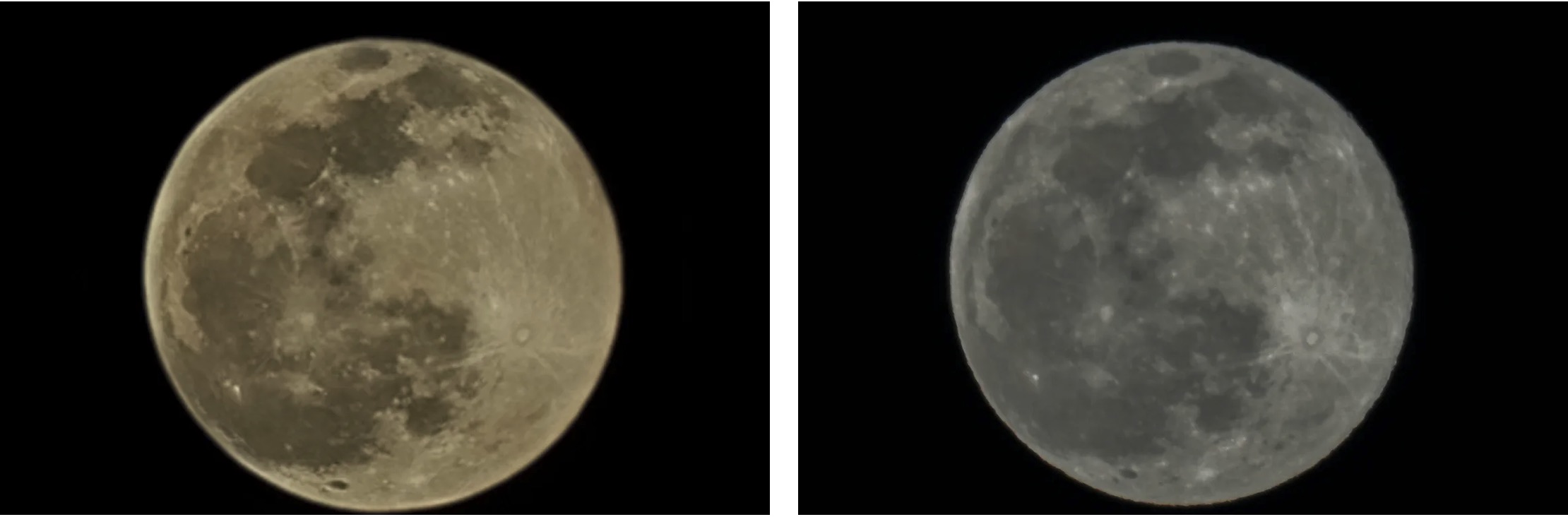

Bài thử của Raymond Wong, một nhiếp ảnh gia kiêm YouTuber nổi tiếng về nhiếp ảnh. Anh này đã dùng một phép thử không thể xác thực hơn về camera của Galaxy S21 Ultra và máy ảnh chuyên nghiệp Sony A7R III cùng ống kính 600mm, tổng giá trị khoảng 6000$ vào thời điểm đó.

Đây là hai hình ảnh thu được từ camera S21 Ultra 100x và ảnh RAW của A7R III (bên phải)

Đây là hình ảnh thu được từ camera S21 Ultra 100x và ảnh JPG đã qua xử lý của A7R III, cho thấy A7R III SAU KHI QUA XỬ LÝ qua Lightroom, cứu highlight, tăng sharpness, texture, clarity... thì thấy ảnh A7R III có nhiều chi tiết hơn

Sau đó, Raymond đặt chồng 2 ảnh của A7R III và S21 Ultra lên nhau, thay đổi màu sắc để chúng ta thấy sự khác biệt về các hình khối (nếu có) của hai sản phẩm này. Kết quả cho thấy hình khối của cả 2 máy gần như tương đồng. Rõ ràng hình ảnh này cho chúng ta thấy Samsung đã không fake các hình khối bề mặt mặt trăng, vì nếu fake thì nó sẽ khác với A7R III ở một mức độ nào đó, không thể tương đồng và gần như giống hệt nhau như vậy.

Raymond còn đi xa hơn khi thử chế độ Scene Optimizer trên S21 Ultra để xem nếu không có nó thì S21 Ultra chụp được gì, thì đây là kết quả. Vậy có thể tạm coi Scene Optimizer là tác nhân giúp S21 Ultra chụp được mặt trăng. Bạn có thể xem toàn bộ những thử nghiệm, kết luận... tại đây

Và đây là một hình ảnh khác mà Raymond chụp mặt trăng bằng camera của Galaxy S21 Ultra zoom 100x và iPhone 12 Pro Max 12x

Okie, vậy bằng chứng một từ Raymond cho thấy Galaxy S21 Ultra và các sản phẩm dùng chung một engine xử lý ảnh sau này không fake hình ảnh mặt trăng, vậy nó thật sự đã làm gì để chụp được mặt trăng đó? Đây là bằng chứng thứ 2 của Samsung, họ đã phản hồi chi tiết về những nghi vấn, của Raymond trong bài viết phía trên, đồng thời đăng tải các bước chi tiết để hiện thực hóa các bức ảnh mặt trăng vào năm 2022, trong một bài viết chính thức bằng tiếng Hàn mà các bạn có thể xem ở đây.

Mình sẽ tóm tắt cho các bạn về các bước xử lý này. Nhưng nó có liên quan đến ArcSoft, một công ty hàng đầu, hay nói đúng hơn là công ty đứng đầu về xử lý ảnh trên điện thoại di động, là kẻ giấu mặt sau hàng loạt công nghệ chụp hình bằng cách ghép nhiều ảnh và xử lý AI của nhiều hãng điện thoại khác nhau. Vị thế của ArcSoft trong engine xử lý ảnh giống với DxOMark của tuning camera, bạn có thể tham khảo lại DxO ở đây, còn ArcSoft khi nào rảnh mình sẽ viết. Bằng cách lục các dòng code trong SDK của Galaxy S21 Ultra, người ta phát hiện ra Samsung đã phối hợp với ArcSoft phát triển các bộ công cụ tự động nhận diện hình ảnh.

Bạn nào già chắc thấy logo ArcSoft quen quen, webcam? photostudio? hehe, từ thời Windows ngày xưa

Sau này thì ArcSoft có đem bán các bộ công cụ này cho các công ty điện thoại khác, tất nhiên là sẽ có những khác biệt so với Samsung nhưng chung cơ chế. Mình nhớ hồi đó phí bản quyền và các chi phí khác cộng lại có thể lên đến vài đô la cho mỗi sản phẩm bản ra, rất rất cao. Và tất nhiên là ngay cả 2021 hay bây giờ thì Samsung cũng từ chối bình luận về ArcSoft và các đối tác khác của họ.

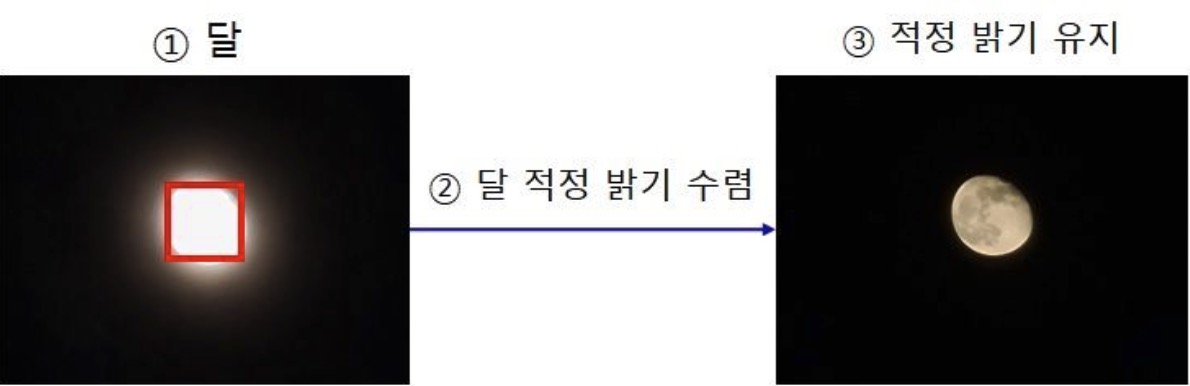

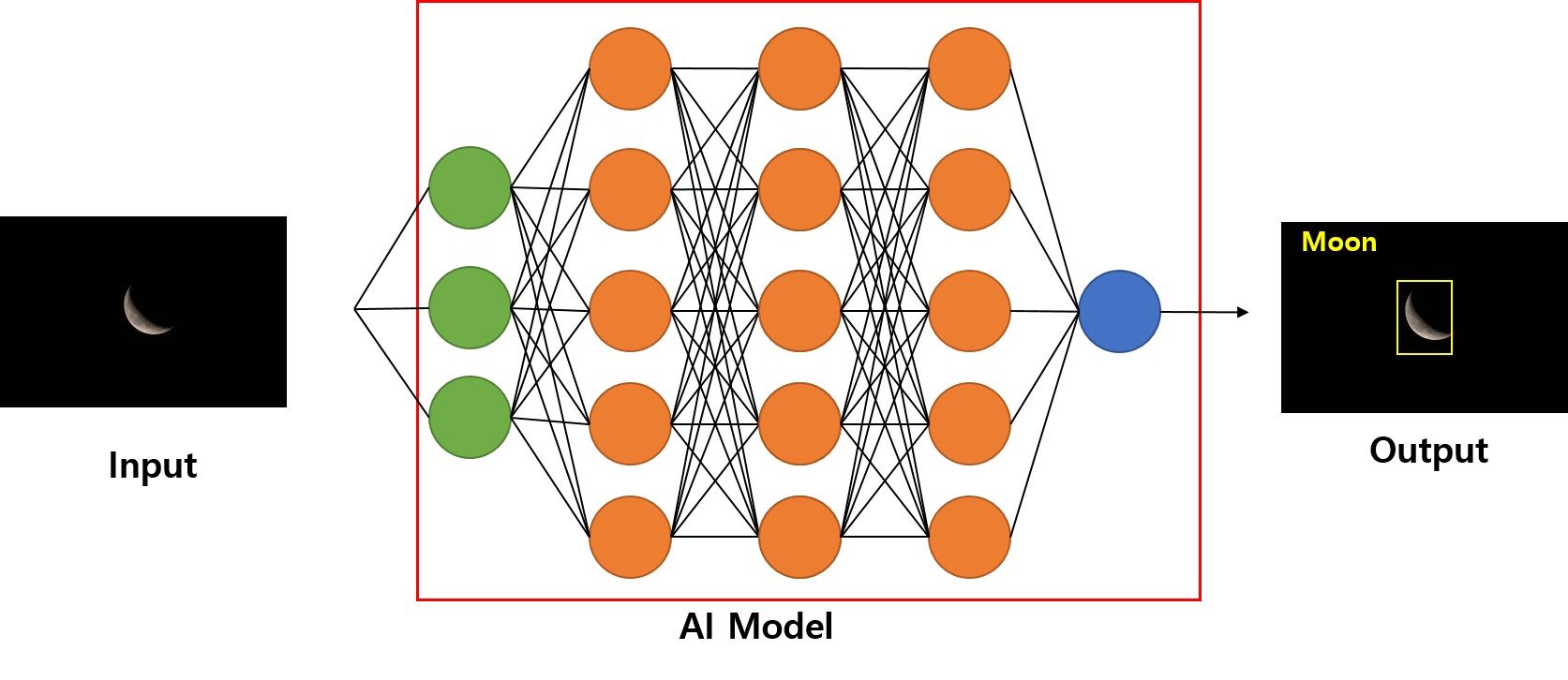

Đây là các bước mà Samsung đã thực hiện để chụp ảnh mặt trăng trên S21 Ultra và các series S về sau:

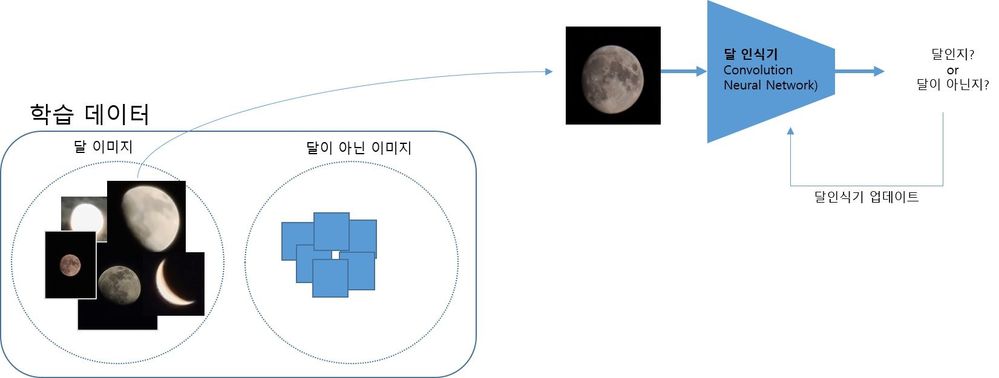

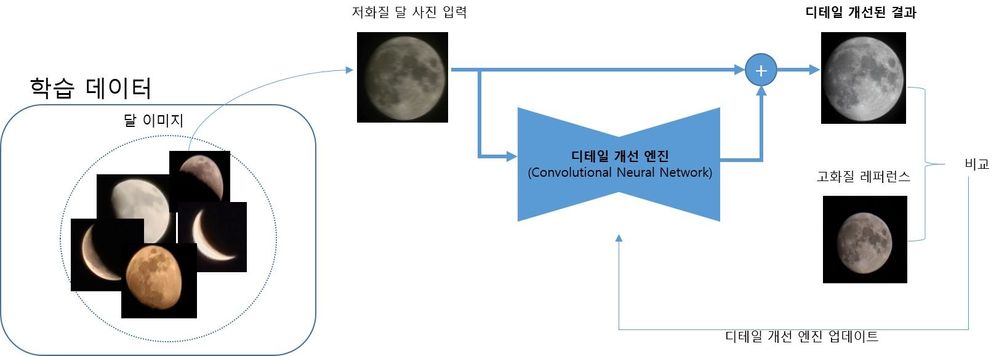

Đầu tiên, khi người dùng kích hoạt chế độ Scene Optimizer ( tạm dịch là tối ưu hình ảnh cho từng khung cảnh), điện thoại Samsung cũng đồng thời kích hoạt chức năng Super Resolution (siêu độ phân giải). Khi này máy sẽ tự động chụp hơn 10 hình ảnh khác nhau ở mức zoom trên 25x trở lên và ghép chúng lại nhằm tạo ra một hình ảnh độ phân giải cao hơn, giảm nhiễu, tăng độ sắc nét và chi tiết.

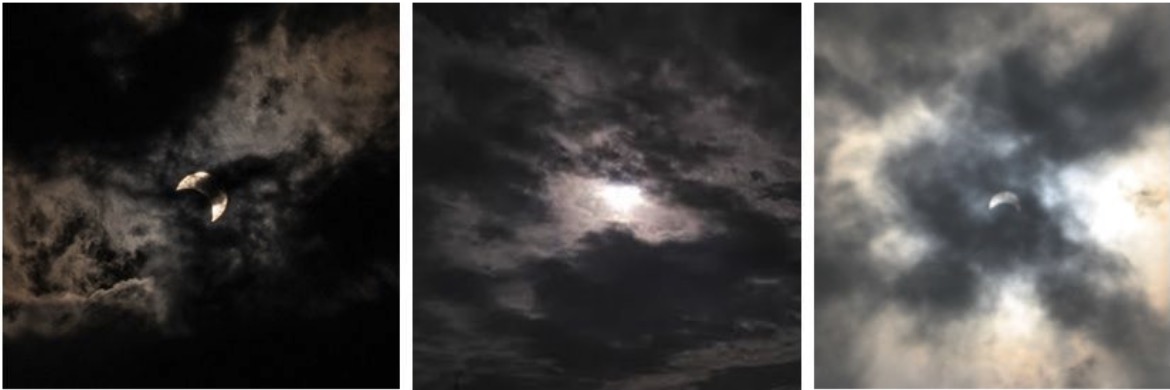

Trong suốt quá trình chụp, độ sáng của hình ảnh sẽ được giảm thật tối để camera thấy rõ các hình khối, chi tiết của mặt trăng, bạn có thể tạm hiểu là giảm EV của ảnh đến tối đa để cứu lấy chi tiết, vì chỉ có mặt trăng là sáng còn vùng trời xung quanh tối, nếu đo sáng trung bình thì toàn bộ ảnh sẽ rất cháy như hình ảnh trên

Trong quá trình chụp, khi chúng ta zoom thì hình ảnh thường sẽ dễ bị rung. Samsung tạo ra cơ chế Zoom Lock, tính năng này kết hợp cả chống rung quang học và chống rung điện tử mà Samsung gọi là VDIS để ảnh cân bằng đến mức tối đa.

Đó là bước sơ bộ về chụp ra hình ảnh, sau đó hình ảnh này được kết hợp với thuật toán trí tuệ nhân tạo để tạo ra hình ảnh cuối cùng sắc nét và chi tiết hơn.

Vậy thuật toán này hoạt động ra sao, nó sẽ dựa vào một cơ sở dữ liệu mà Samsung thu thập từ trước, bất kể mặt trắng đó là tròn hay bán nguyệt hay các hình dạng khác. Thuật toán có khả năng nhận diện vùng của mặt trăng, do vậy nó vẫn biết đó là mặt trăng kể cả khi bị che khuất một phần. Nhưng để làm vậy thì nó phải chạy qua một cơ chế nhận diện trước đó để xem hình ảnh chụp lại vừa rồi có phải mặt trăng thật hay không.

Nếu phải, các hình ảnh chụp sẽ được ghép lại bằng thuật toán Multi-frame processing với tối thiểu 10 tấm như đã nói ở trên để giảm nhiễu.

Nhưng mà có giảm thì vẫn quá nhiều và không thật sự sắc nét do mặt trăng ở quá xa và quá mờ, và ở đây chúng ta lại thêm một thuật toán nữa là Detail Enhancement để tăng chi tiết cho ảnh.

Tất nhiên là thuật toán nào cũng có hạn chế, ví dụ như trường hợp này thì nó sẽ không nhận diện được.

Như vậy, bạn đã thấy Samsung công bố rất rõ về flow xử lý của họ, và thực tế cũng đã chứng minh nó thật sự không fake vì nếu bạn chụp mặt trăng đỏ, thì ảnh ra sẽ là mặt trăng đỏ, khối chi tiết thế nào thì ảnh ra cũng khối chi tiết thật như vậy.

Đầu vào, và đầu ra sau khi xử lý

4. Đâu là giới hạn của ảnh AI và đâu là giới hạn của một bức ảnh thật

Nếu như phần trên là "giải oan" cho Samsung, thì phía dưới này là suy nghĩ của mình cho những bức ảnh chụp bằng điện thoại. Mình để chữ "giải oan" và "vô tội" trong ngoặc kép vì chúng ta chưa hề có khái niệm nào về ranh giới, về những giới hạn của việc áp những thuật toán trí tuệ nhân tạo vào ảnh cả.

Hãy thử tưởng tượng thế này:

- Bạn dùng AI để làm mờ hậu cảnh phía sau, tạo hiệu ứng xóa phông mạnh mẽ, thì rõ ràng hình ảnh đó không còn thật nữa rồi, vậy AI can thiệp vào có đúng hay không?

- Bạn dùng AI để bóp má, làm cho mặt gầy hơn hay mắt long lanh hơn, chỉ một chút thôi, vậy đó có phải là một bức ảnh sai sự thật hay không?

- Bạn thấy một người nào đó thừa trong khung hình, dùng Magic Eraser của Google để xóa họ đi, vậy bức ảnh đó có còn giá trị?

- Hình ảnh người ông đã mất của bạn bị mờ, dùng AI để "vẽ" lại, làm cho bức ảnh đó sắc nét hơn, vậy điều đó có đúng không?

- Một bức ảnh chụp rung tay, bị mờ nặng, AI cứu nó có được không?

- Hay đơn giản hơn, nếu dùng Live Photo trên iPhone, bạn thường xuyên chọn lại một khoảnh khắc nào đó trong video preview chất lượng kém của ảnh, sau đó AI sẽ tự vẽ lại ảnh chất lượng cao cho khoảnh khắc đó, liệu bức ảnh đó có sai hay không?